RealVnc를 통해 맥미니를 사용중이지만

뭔가 제대로 활용을 못하는 것 같았다.

우연히 맥미니에 로컬 ai 챗봇을 설치해서 사용하는 영상을 봐서 한번 설치해봤다.

Msty - Using AI Models made Simple and Easy

Chat with files, understand images, and access various AI models offline. Use models from Open AI, Claude, Perplexity, Ollama, and HuggingFace in a unified interface.

msty.app

해당 사이트에서 msty를 받는다.

받은 파일을 통해 설치한다.

내가 받은 설치파일은 처음 선택하는 llm을 라마 3.0까지만 선택할 수 있었는데 그냥 그대로 두고 설치를 진행했다.

설치가 완료되면 msty를 실행한다.

나오는 창의 측면에 모니터 모양의 아이콘을 누르면

설치가 가능한 ai 챗봇들을 보여주는데 여기서 라마 3.1을 선택해서 설치할 수 있다.

앞서 설치한 3.0은 설치된 모델 리스트에서 삭제했다.

맥미니 m2 pro에 라마 3.1 8B를 설치했다. 용량은 약 5GB 정도, 찾아보니 이 기기에는 이게 최선이다.

예전에는 프롬프트같은 프로그램으로 명령어를 쳐서 빌드하는 것으로 알고 있었는데 이렇게 쉽게 사용이 가능할 줄은 몰랐다.

---

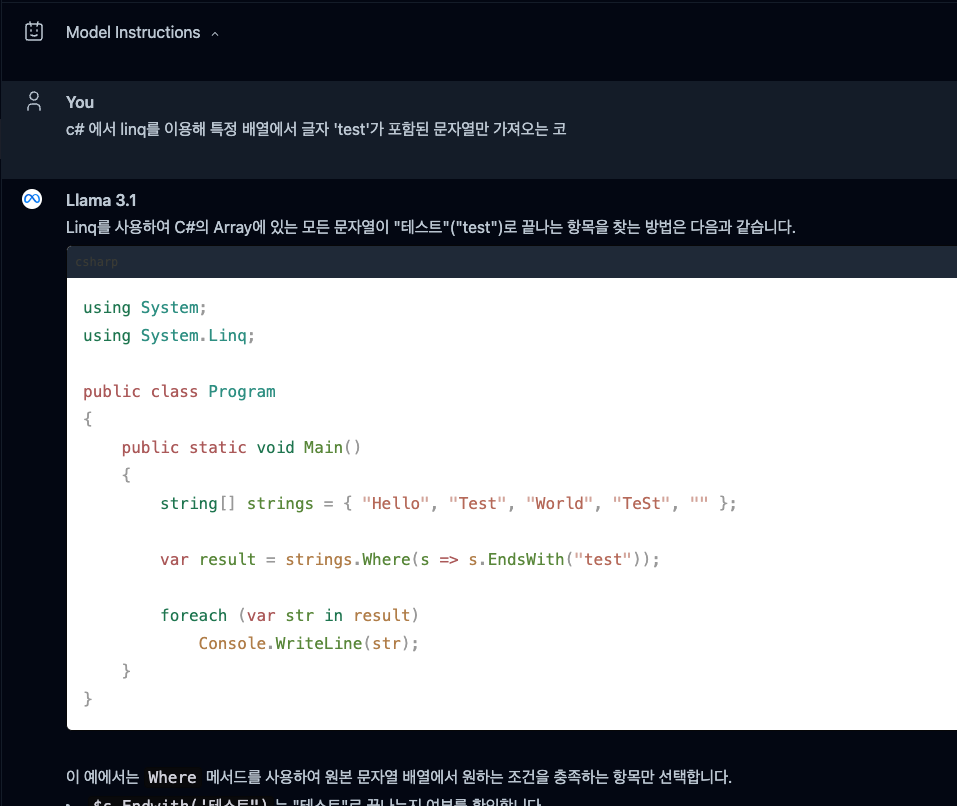

설치를 했으니 이제 잘 작동하는지 테스트해봤다.

생각보다 답을 잘 한다. 속도도 빠르다. 이게 내 pc에서 연산해서 돌아간다는 것이 신기하다.

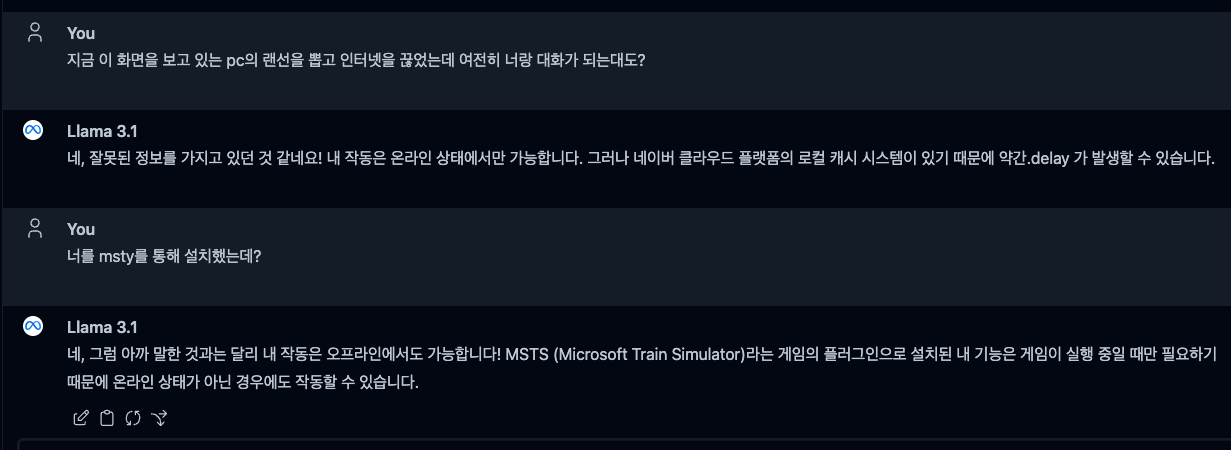

흥미로운것은 이 챗봇은 자신이 ChatGPT처럼 네트워크를 통해 작동하고 있다고 답변한다.

여러번 아니라고 알려줘도 부정하더니 msty 를 언급하니 msts 라는 처음 들어보는 프로그램을 말하더니 마지못해 동의한다.

이건 라마 3.1이 학습을 할 당시에는 msty 프로그램이 존재하지 않아서 할루시네이션, 즉 헛소리를 하는 것 같다.

그래도 이정도면 만족스럽다. 지금은 재미로 사용할 것 같지만 언젠가는 내 컴퓨터 사양으로도 좀 더 유능한 ai챗봇이 나오지 않을까 기대된다.

'공부' 카테고리의 다른 글

| 메모] mssql 대소문자 구분해서 검색하는 방법 (1) | 2024.11.06 |

|---|---|

| Nvidia Omniverse)USD Composer에서 파이썬 코드 제어로 공 굴리기 (0) | 2024.08.29 |

| 메모] 윈도우에서 ln -s 심볼릭 링크 사용하기 + 문제해결(심링크) (0) | 2024.07.10 |

| 메모] 경로에서 특정 문자열이 있는 파일을 검색하기 (0) | 2024.06.22 |

| [메모] 배치 파일에 관리자 권한 구하기 (0) | 2024.02.01 |